Une application peut passer tous ses tests logiciels et pourtant générer un incident quelques jours après sa mise en production.

Un tunnel d’achat validé peut ralentir sous charge. Une API testée peut devenir intermittente. Un parcours mobile peut se dégrader à certaines heures.

Ce n’est pas une contradiction technique. C’est le résultat d’une confusion fréquente : croire que tester un logiciel revient à le sécuriser durablement.

Les tests valident. Le monitoring en production surveille.

Ces deux disciplines poursuivent le même objectif, la fiabilité applicative, mais elles n’interviennent ni au même moment, ni avec la même finalité.

Et les confondre crée une illusion de couverture.

Dans un contexte où le digital génère du chiffre d’affaires, pilote l’expérience client et structure la relation utilisateur, cette confusion peut devenir coûteuse.

Le test logiciel : sécuriser avant la mise en production

Le test logiciel intervient en amont. Il s’inscrit dans le cycle de développement et permet de valider que le logiciel fait ce qu’il est censé faire.

Les principaux types de tests

On distingue généralement :

- Tests unitaires

- Tests d’intégration

- Tests fonctionnels

- Tests automatisés

- Tests de non-régression

- Tests E2E (End-to-End)

Chaque test vérifie un comportement attendu :

- un bouton déclenche la bonne action,

- une API renvoie la réponse prévue,

- une évolution n’a pas cassé l’existant.

Les tests réduisent le risque avant mise en ligne. Ils structurent la qualité.Ils sécurisent une version. Mais ils s’exécutent dans un environnement maîtrisé.

Ce que les tests garantissent réellement

Un test valide un scénario connu. Il répond à la question :

Le logiciel est-il conforme aux spécifications ?

Il ne répond pas à :

Comment le logiciel se comporte-t-il réellement dans la durée, sous charge et en conditions réelles ?

Même avec une excellente couverture de tests, certaines variables échappent à cette validation :

- la variabilité des réseaux mobiles,

- les pics de trafic imprévus,

- les latences intermittentes d’API tierces,

- les interactions simultanées entre services,

- les comportements utilisateurs atypiques.

Les tests sécurisent la conception. Ils ne sécurisent pas l’exploitation.

Pourquoi la production change la donne

La production n’est pas un laboratoire. C’est un environnement :

- dynamique,

- évolutif,

- interconnecté,

- dépendant d’acteurs tiers.

Un scénario validé en pré-production peut se dégrader en production pour des raisons qui ne relèvent pas d’une erreur de code :

- surcharge ponctuelle,

- dépendance externe instable,

- infrastructure partiellement dégradée,

- interaction inattendue entre systèmes.

Le test s’arrête à la mise en ligne. La réalité commence à la mise en ligne.

Le monitoring applicatif : surveiller la réalité en continu

Le monitoring applicatif intervient exclusivement en production. Il observe un système vivant.

Il permet de surveiller :

- les temps de réponse,

- les taux d’erreurs,

- la disponibilité,

- les transactions critiques,

- les parcours utilisateurs complets.

Il répond à une autre question :

Le service fonctionne-t-il correctement pour les utilisateurs, maintenant ?

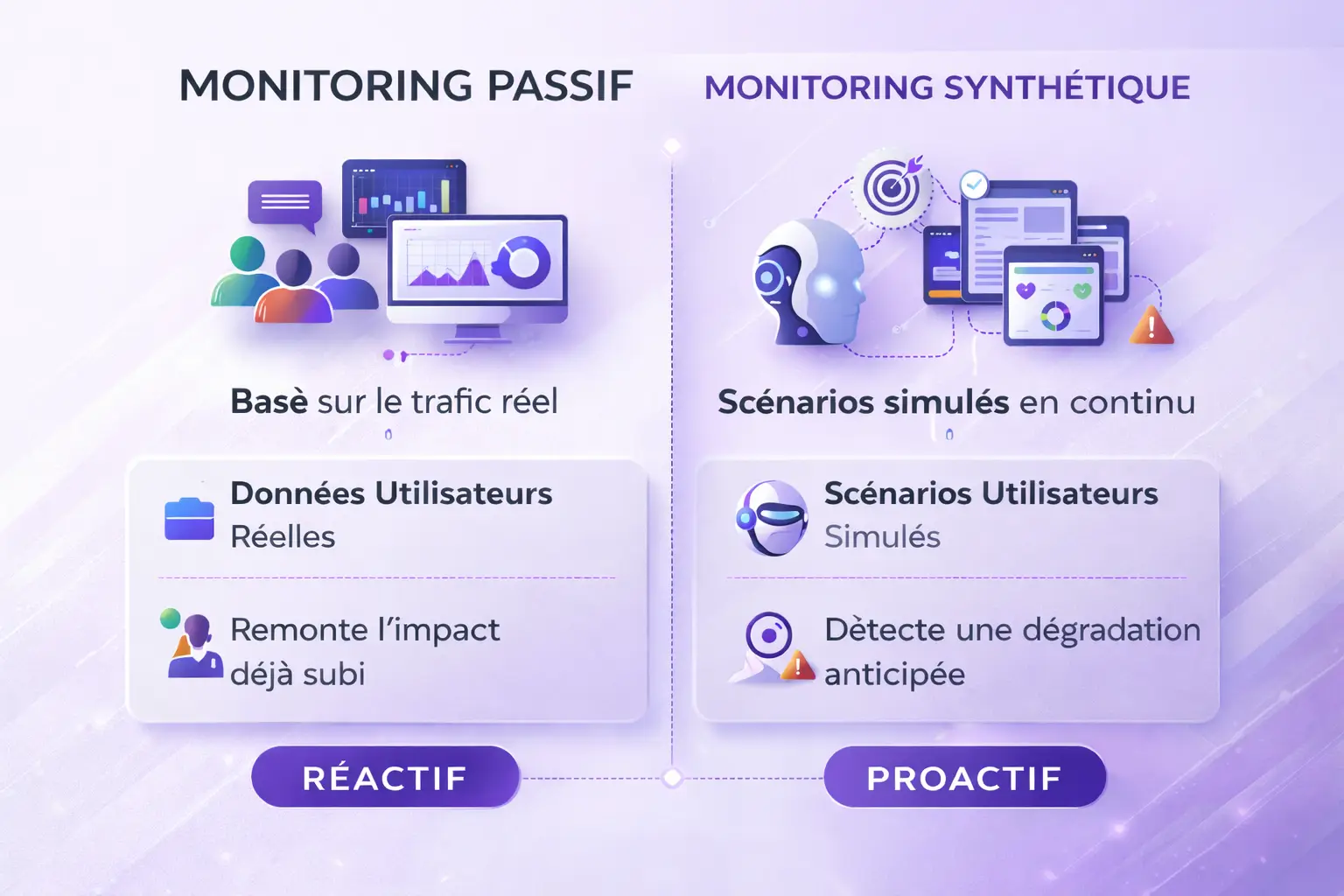

Monitoring passif vs monitoring synthétique

Le monitoring passif (RUM, logs, métriques) analyse les données issues du trafic réel. Il détecte un problème lorsque des utilisateurs ont déjà été impactés.

Le monitoring synthétique, lui, rejoue en continu des scénarios utilisateurs prédéfinis, indépendamment du trafic réel.

Par exemple :

- connexion,

- recherche,

- ajout au panier,

- paiement,

- confirmation.

C’est le principe du monitoring transactionnel des parcours critiques. Cette approche permet d’identifier une dégradation avant qu’elle ne devienne massive.

Exemple concret : un parcours validé… mais dégradé en production

Prenons un parcours bancaire mobile. Les tests ont validé : authentification OK, consultation compte OK, virement OK.

En production, sous forte charge : l’API de virement ralentit, le temps de réponse dépasse 5 secondes, certains utilisateurs abandonnent.

Aucun test n’a échoué. Mais seule une surveillance des parcours utilisateurs en production aurait permis de détecter immédiatement la dérive.

La différence est claire : Le test valide une version. Le monitoring protège l’exploitation.

Ce que coûte la confusion entre test et monitoring

Confondre validation et surveillance expose à plusieurs risques.

Impact business

- baisse du taux de conversion,

- abandon panier,

- perte transactionnelle,

- chiffre d’affaires non réalisé.

Impact réputationnel

- perception d’instabilité,

- frustration utilisateur,

- érosion de la confiance.

Impact organisationnel

- incidents détectés par les clients,

- pilotage réactif,

- diagnostic tardif.

Dans certains secteurs régulés, la maîtrise continue devient un enjeu structurant.

Monitoring interne ou solution dédiée ?

Certaines organisations développent leur propre supervision. Limites fréquentes :

- maintenance lourde,

- dépendance aux équipes internes,

- couverture partielle,

- manque d’indépendance.

Cela est particulièrement critique pour :

- le monitoring application mobile en production

- la surveillance des API stratégiques

- le monitoring des parcours SVI

Surveiller depuis l’intérieur n’est pas équivalent à observer l’expérience réelle.

L’approche orientée parcours : surveiller ce que vivent réellement les utilisateurs

Chez 2Be-FFICIENT, la logique n’est pas centrée sur l’infrastructure. Elle est centrée sur les parcours générateurs de valeur.

Cela signifie :

- rejouer régulièrement des scénarios web,

- surveiller sur terminaux mobiles réels,

- contrôler des transactions critiques,

- détecter les dégradations progressives.

Le monitoring synthétique ne remplace pas les tests. Il complète la chaîne de fiabilité.

Construire un cycle vertueux entre tests et monitoring

Les tests et le monitoring ne s’opposent pas. Ils forment un cycle.

- Les tests sécurisent la version.

- La production expose le système au réel.

- Le monitoring détecte les anomalies.

- L’analyse identifie les causes.

- De nouveaux tests sont intégrés.

La fiabilité applicative repose sur cette boucle continue.

Trois questions pour évaluer votre maturité

- Qui détecte les incidents : vos équipes ou vos utilisateurs ?

- Surveillez-vous des serveurs ou des parcours critiques ?

- Disposez-vous d’une surveillance continue indépendante ?

FAQ – Test vs Monitoring

Le monitoring remplace-t-il les tests ?

Non. Les tests valident la conformité. Le monitoring surveille la performance réelle en production.

Peut-on se contenter de tests automatisés ?

Non. Les tests sécurisent une version, pas son comportement dans le temps.

Quelle différence entre monitoring applicatif et monitoring synthétique ?

Le monitoring applicatif observe la santé du système. Le monitoring synthétique rejoue des scénarios utilisateurs en continu.

Conclusion

Les tests sont indispensables. Le monitoring est structurant. Les tests valident ce qui a été prévu. Le monitoring détecte ce qui n’avait pas été anticipé.

Dans un environnement digital exigeant, la fiabilité ne peut pas reposer uniquement sur une validation initiale. Elle repose sur un équilibre :

- rigueur en amont,

- surveillance continue,

- amélioration permanente.